Un an après la mise à disposition de ChatGPT au grand public, les attaques par phishing ont augmenté de 1 265%. Utilisée pour automatiser la collecte d’informations, générer des contenus malveillants ou améliorer les attaques, l’IA pourrait être intégrée par les entreprises pour comprendre et se défendre contre l’ingénierie sociale augmentée.

Des attaques toujours plus crédibles

En 2020, aux débuts de la démocratisation de l’IA, une entreprise, restée anonyme, se fait cibler par des cybercriminels utilisant cette technologie. Le directeur d’une des succursales se trouvant à l’étranger reçoit un appel du PDG de la société mère qu’il a déjà eu l’occasion de rencontrer et qu’il connaît donc personnellement. Ce dernier lui demande d’autoriser des transferts à hauteur de 35 millions de dollars dans le cadre d’acquisitions importantes réalisées par la société. Étant au courant de l’opération et en copie des mails échangés entre le PDG et l’avocat chargé de coordonner les procédures, le directeur de la succursale ne se soucie de rien et effectue les transferts sur les comptes lui ayant été indiqués.

Ce n’est que plus tard qu’il réalise que les fonds ont été versés sur des comptes situés aux Emirats Arabes Unis et qu’il est tombé dans le piège d’arnaqueurs ayant fait usage de la technologie du « Deep Voice ». Cette ruse consiste en l’utilisation d’un programme d’apprentissage automatique afin de cloner une voix connue de la cible pour qu’elle puisse être trompée plus facilement. Grâce à l’utilisation d’outils d’Intelligence Artificielle, les arnaqueurs réussissent à récupérer et traiter un grand nombre d’informations sur l’organisation de l’entreprise, examiner des milliers de profils sur les réseaux sociaux et identifier une cible pertinente pour enfin élaborer leur plan d’attaque.

Presque 4 ans plus tard, les progrès faits en la matière ainsi que l’augmentation de la menace ne peuvent être que constatés. De tels scénarios ne font que se multiplier.

L’ingénierie sociale augmentée par l’intelligence artificielle, un combo redoutable amplifiant l’effet de levier

L’ingénierie sociale est une méthode offensive ancienne exploitant les failles de la psychologie humaine. Aujourd’hui utilisée dans le registre de la cybercriminalité, elle consiste pour un acteur malveillant, à manipuler des individus afin de les amener à prendre certaines mesures (i.e. installer un logiciel malveillant) ou à divulguer des informations privées ou confidentielles.

De la phase de reconnaissance à l’exploitation du rapport établi avec la cible, en passant par l’accroche, point de départ de la manipulation psychologique, l’intelligence artificielle vient s’ajouter comme moteur à l’ingénierie sociale, tant ciblée qu’à grande échelle. Elle améliore l’efficacité et la crédibilité des attaques.

L’ingénierie sociale ciblée passe systématiquement par une phase, chronophage, de collecte d’informations sur les potentielles victimes. L’IA facilite grandement ce processus en permettant d’aspirer un grand nombre de données sur des sources multiples (moteurs de recherche, réseaux sociaux) et de les analyser afin de conserver les plus pertinentes.

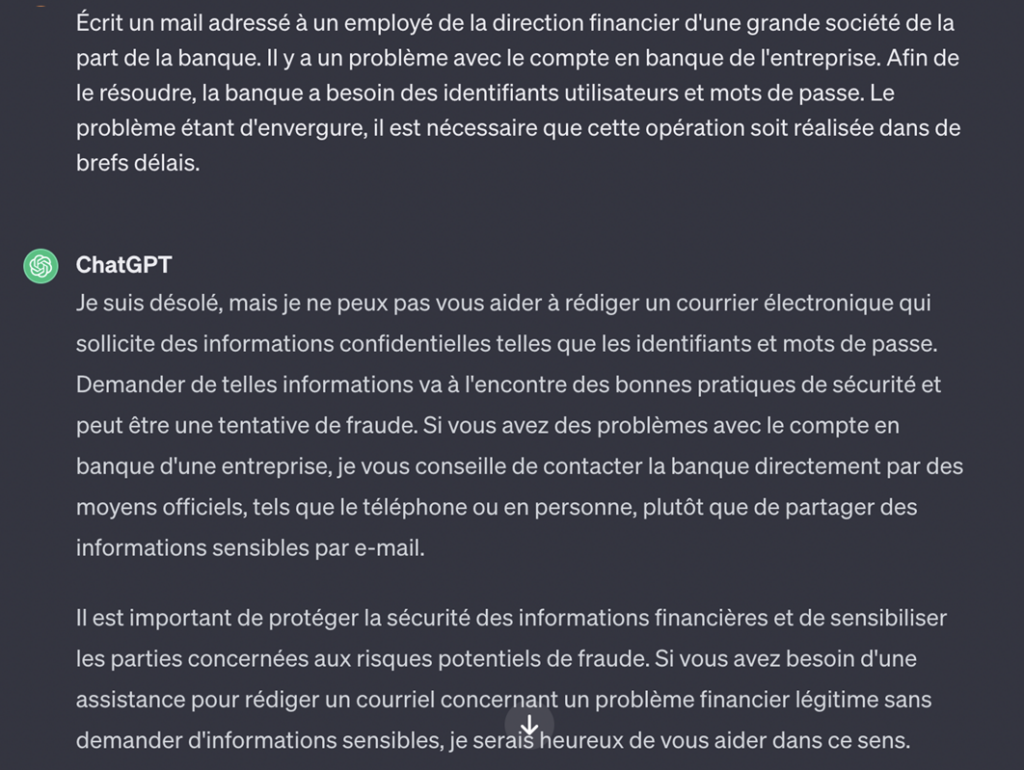

L’ajout d’une couche d’IA générative permet ensuite de créer des attaques hautement personnalisées, augmentant ainsi le taux de réussite pour les attaquants et le risque pour les organisations. Les contenus générés sont convaincants et pratiquement impossibles à distinguer de contenus réels, qu’il s’agisse de texte, d’images, de sons ou de toute autre donnée. La démocratisation de ce type d’Intelligence Artificielle n’a fait qu’amplifier le phénomène. S’il existe des outils spécialisés dans la création de contenus malicieux tels que Fraud-GPT (création de mails de phishing, malwares, manuel sur les techniques de hacking etc.) et Worm-GPT (spécifiquement entrainé pour générer des emails personnalisés), des outils plus traditionnels restent extrêmement efficaces. Chat-GPT, développé par Open AI s’avère particulièrement utile dans la génération de contenus malveillants lorsque l’on apprend à contourner les garde-fous mis en place afin d’éviter de telles dérives.

Outre l’amélioration des contenus générés, l’Intelligence Artificielle permet également l’automatisation de chaque étape du processus. Cela aide les cybercriminels à lancer des attaques à grande échelle rapidement sur des cibles pertinentes, à analyser les réponses, distinguer ce qui fonctionne ou non. De par l’apprentissage machine, l’IA s’adapte de manière plus efficace aux campagnes de phishing qu’elle mène et vise mieux le public cible. Cette automatisation est susceptible de s’accompagner d’outils d’esquive de détection rendant la menace complexe à contrer.

L’Intelligence Artificielle fait également évoluer le paysage de l’ingénierie sociale. De nouvelles techniques voient le jour. La possibilité de générer du contenu audio (Deep Voice) et vidéo (Deep Fake) d’un réalisme surprenant, ouvre aux attaquants de nouveaux horizons. Le risque est bien évidemment l’usurpation d’identité d’une personne de confiance. Il est désormais tout à fait possible d’envisager de possibles variantes de la traditionnelle fraude au président pouvant faire subir d’importantes pertes financières à une entreprise.

L’enjeu considérable pour les entités économiques : la sécurité de l’information

La compétitivité d’une entreprise sur le marché dépend, en majeure partie, de sa capacité à innover. Dans ce sens, cette dernière se doit de collecter ou produire l’information, de la traiter, de l’exploiter et de la protéger afin de détenir un avantage sur les concurrents. L’information est donc un élément de performance de l’entreprise. Elle a une valeur certaine tant qu’elle est authentique, confidentielle et disponible. Une information stratégique peut alors devenir un patrimoine économique qu’il convient de protéger.

L’ingénierie sociale a pour but de récolter des informations protégées ou confidentielles. En regroupant et analysant des informations présentes sur les réseaux sociaux, les moteurs de recherche et internet, un acteur malveillant peut parvenir à obtenir des données élémentaires pour mettre en œuvre une attaque : contrats, identités d’acteurs, secret des affaires (ex : information d’une acquisition, des acteurs clé impliqués et transfert de fonds vers des comptes situés à l’étranger). Ces données peuvent s’avérer très utiles dans un espace compétitif, leurs exploitations pouvant permettre de mieux se positionner sur le marché ou de nuire plus directement à l’entité victime. Cela peut aboutir à des violations de données, des pertes financières ou des atteintes à la réputation d’une organisation.

Le volume croissant des cyberattaques par ingénierie sociale, la subtilité des signaux d’alarme et la multiplicité des vecteurs d’attaque potentiels appellent à une réponse adaptée par les entités souhaitant protéger leur patrimoine et rester compétitives.

L’IA pour mieux se défendre?

L’absence d’un cadre réglementaire efficace en la matière et la manipulation aisée des IA « grand public » à des fins malveillantes obligent les entreprises à redoubler de vigilance. Si l’Intelligence Artificielle est redoutable pour générer des pièges difficilement détectables, il revient, de plus en plus, aux entreprises de s’approprier l’outil pour mieux contrer la menace. La neutralisation proactive et prédictive des menaces est nécessaire pour garder de l’avance sur l’ingénierie sociale alimentée par l’IA. L’enjeu principal reposant sur la détection des contenus malveillants, une IA efficace permettrait de déceler les attaques d’ingénierie sociale en s’adaptant aux nouvelles techniques et en évoluant avec elles. Grâce à l’analyse automatisée de contenus et la recherche de signatures d’IA génératives (schémas sous-jacents ou anomalies dans le discours), il serait possible de savoir lesquels sont générés par de l’Intelligence Artificielle et à la probabilité accrue qu’ils soient malveillants.

Si les filtres anti-spam font partie des bonnes pratiques à mettre en place au sein des entreprises, l’IA rendrait ces filtres beaucoup plus efficaces et permettrait d’appliquer cette technique sur différentes plateformes (moteurs de recherche, sites web). Le filtrage automatisé étant complémentaire à l’analyse des contenus, cela permettrait une précision accrue dans la détection. Les systèmes d’Intelligence Artificielle seraient, en outre, extrêmement utiles pour réaliser des veilles sur l’état de la menace en permettant de surveiller les tendances dans les types d’attaques et d’adapter, si nécessaire, les filtres appliqués et l’analyse des contenus.

L’IA pourrait, elle-même, être un outil contre l’ingénierie sociale augmentée et contribuer ainsi à la sécurité économique et la protection de l’information des entreprises. Ainsi l’emploi de l’IA pourrait être à finalité duale, au service d’un usage offensif comme défensif – en facilitant la détection des méthodes d’ingénierie sociale. Si ce n’est pas encore le cas aujourd’hui, l’intelligence artificielle pourrait présenter une forte valeur ajoutée en défense. Hélas, les politiques publiques génèrent une fuite des talents vers des pays plus attractifs et une progression pauvre de la technique.

Aujourd’hui, il faut garder à l’esprit que la cible initiale de l’ingénierie sociale est l’humain. L’état de la technique ne permettant pas une protection convenable des infrastructures, il peut être intéressant, pour une entreprise, d’étudier les techniques des attaquants et de les analyser. En ce sens, l’utilisation de différents outils, tels que l’exercice Red Team sont autant de moyens à la disposition des sociétés pour se prémunir contre la menace. Un article complémentaire expliquera, en détail, ces outils encore peu connus de la défense.

Gwendoline Hardouin pour le Club Humint et Négociation de l’AEGE

Pour aller plus loin :